CAD / GIS-plattformer må gå til GPU

De av oss som bruker grafiske applikasjoner forventer alltid at datamaskinene har nok arbeidsminne. I dette har CAD / GIS-programmer alltid blitt stilt spørsmålstegn eller målt basert på tiden det tar å utføre daglige aktiviteter som:

- Romlig analyse

- Rektifisering og registrering av bilder

- Utplassering av massive data

- Datastyring innenfor en geodatabase

- Datatjeneste

Den tradisjonelle PC-en har ikke endret seg mye de siste årene, når det gjelder RAM, harddisk, grafikkminne og funksjoner som bare har økt; men operasjonslogikken til CPU har opprettholdt sin opprinnelige design (Det er derfor vi fortsetter å kalle ham CPU). Det har også vært en ulempe at ettersom team vokser i evner, dreper programmer deres forventninger ved å designe seg for å konsumere nytt potensial.

Som et eksempel (og eneste eksempel) Når to brukere som er plassert på samme tid under de samme betingelser for utstyr og data, en AutoCAD 2010 og ett med Micro V8i, lasting 14 rasterbilder, en parcelario fil 8,000 egenskaper og tilkobling til en romlig database Oracle, vi spør oss selv:

Hva har en av de to, for ikke å kollapse maskinen?

Svaret ligger ikke i innovasjon, det er rett og slett måten programmet er utviklet på, fordi dette ikke er tilfelle med AutoDesk Maya, som gjør galere ting og presterer bedre. Måten å utnytte PC-en på er den samme (så langt i tilfelle de to programmene), og basert på dette skyter vi programmene, fordi vi bruker dem til å jobbe, og mye. Dermed er noen datamaskiner kjent som tradisjonelle PC-er, arbeidsstasjoner eller servere; ikke fordi de har en annen farge, men på grunn av måten de kjører programmer med høyt forbruk på grafisk design, videobehandling, applikasjonsutvikling, serverfunksjoner og i vårt tilfelle drift med romlige data.

Mindre CPU, mer GPU

Den mest fremragende de siste endringene som har skjedd til arkitekturen av PCer er begrep skapt GPU (Process Unit Graphics), for å finne et bedre datamaskinens ytelse, noe som gjør gode rutiner i små samtidige oppgaver, utenom administrasjon av CPU (Central Processing Unit), som har arbeidskapasitet mellom omdreininger på harddisken, RAM-minnet, videominnet og blant annet opplysninger (ikke mange andre).

Grafikkort er ikke laget for å øke videominnet, men inkluderer heller en prosessor som inneholder hundrevis av kjerner designet for å kjøre parallelle prosesser. Dette har de alltid hatt (mer eller mindre), men den nåværende fordelen er at disse produsentene tilbyr en viss åpen arkitektur (nesten) slik at programvareutviklere kan vurdere eksistensen av et kort med disse mulighetene og utnytte potensialet. PC-magasinet i januar nevner selskaper som nVidia, ATI og andre som er inkludert i alliansen OpenCL

For å forstå forskjellen mellom CPU og GPU, her refererer jeg til en simulering:

CPU, alt sentralisertDet er som en kommune med alt sentralisert, som har byplanlegging, vet at den må kontrollere veksten, men ikke er i stand til å føre tilsyn med selv de nye konstruksjonene som bryter normene. Men i stedet for å gi denne tjenesten til private selskaper, insisterer han på å påta seg rollen, befolkningen vet ikke hvem de skal klage på om naboen som tar fortauet, og byen fortsetter å bli mer uorden hver dag.

Beklager, snakket ikke om ordføreren din, bare snakket om en simulering av CPU, hvor denne sentrale prosessenheten (i tilfelle av Windows) burde få laget til å utføre i prosesser som:

- Programmer som kjører når Windows starter, for eksempel Skype, Yahoo Messenger, Antivirus, Java Engine, etc. Alt forbruker en del av arbeidsminnet med lav prioritet, men unødvendig med mindre det er modifisert av msconfig (som noen ignorerer).

- Tjenester som kjører, som er en del av Windows, vanlige programmer, tilkoblet maskinvare eller andre som ble avinstallert, men som fortsatt kjører. Disse har vanligvis middels / høy prioritet.

- Programmer i bruk som bruker plass med høy prioritet. Vi føler deres utførelseshastighet i leveren vår fordi vi forbanner hvis de ikke gjør det raskt til tross for at de har et team med høy ytelse.

Og selv om Windows gjør sin jonglering, har praksis som å ha mange programmer åpne, installere eller avinstallere uansvarlig, unødvendige emner som ses pintones, de gjør oss skyldige i feilen i utstyret.

Det skjer da, at når vi starter en prosess med de nevnte i begynnelsen, vil prosessoren konkurs kokosnøtten ønsker å prioritere dette fremfor de andre programmene i bruk. De få alternativene dine for å optimalisere er RAM-minne, videominne (som ofte deles), hvis det er et grafikkort, kan du få noe ut av det, avhengig av typen harddisk og andre bagateller, kan det ynkelige stønnet være mindre.

GPU, parallelle prosesser, Det er som kommunen bestemmer seg for å desentralisere, konsesjon eller privatisere de tingene som er utenfor rekkevidden, selv om de er store prosesser, blir levert i små oppgaver. Basert på gjeldende regelverk får et privat selskap således rollen som spesielt å overvåke straffbare brudd. Som et resultat (bare et eksempel), kan borgeren oppfylle den deilige glede av å fortelle ribbenene til naboen som tar hunden ut cagarse på fortauet hans, som bygger en vegg ved å ta en del av fortauet, som parkerer bilen sin feil osv. Selskapet svarer på samtalen, går til stedet, behandler handlingen, fører den for retten, utfører boten, halvparten går til kommunen, den andre er en lønnsom virksomhet.

Slik fungerer GPU, programmene kan utformes slik at de ikke sender massive prosesser på konvensjonell måte, men de går parallelt med små filtrerte rutiner. Oh! fantastisk!

Inntil nå er det ikke mange programmer som lager applikasjonene sine med disse funksjonene. De fleste av dem, de ønsker å nå 64 biter for å løse problemer med treghet, selv om vi alle vet at Don Bill Gates alltid kommer til å gå i disse kapasitetene ved å laste unødvendige ting på de neste versjonene av Windows. Windows 'strategi inkluderer å dra nytte av GPU gjennom API-er designet for å fungere på DirectX 11, som helt sikkert vil være et alternativ som alle (eller de fleste) vil akseptere fordi de foretrekker det som en standard i stedet for å gjøre sprø ting for hvert merke utenfor OpenCL.

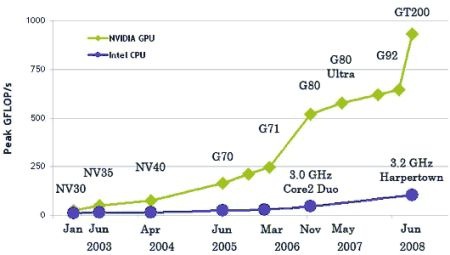

Grafen viser et eksempel som viser hvordan nVidia-prosessoren mellom GPU og GPU har revolusjonert sine evner mellom 2003 og 2008 sammenlignet med Intel-prosessoren. Også røkt forklaring av forskjellen.

Men potensialet til GPU er der, forhåpentligvis og CAD / GIS-programmer får den nødvendige juice. Det er allerede hørt, selv om den mest fremragende saken er d

e Manifold GIS, med CUDA-kort, fra nVidia, der en genereringsprosess for digital terrengmodell som tok mer enn 6 minutter ble utført på bare 11 sekunder, og utnyttet eksistensen av et CUDA-kort. Røkte det som gjorde dem vinne Geotech 2008.

Konklusjon: Vi går til GPU, vi vil sikkert se mye de neste to årene.

Hei Vicente, jeg ser at du ser ut til å bli vant til Windows 7.

Er det noe du savner om xP?

Er det grunner til at jeg ikke ville gå tilbake til XP?

Windows 7 i 64bit lar deg fortsatt installere applikasjoner i 32bit ... Og så langt sluttet ingen av GIS-programmene mine å fungere.

"Har du forresten prøvd Manifold på 64-bit?"

Nup…. Selv om den ydmyke PC-en min har en 64-bit AMD, ønsket jeg ikke å installere Windows 64 som en bunke med applikasjoner og drivere ville være ute av bruk. Jeg tror trinnet ville være å ha en dedikert PC og installere alt på 64bits.

Jeg har ingen tvil om at Manifold være en av de programmene som vil kjøre under 64 deres forskjell biter, og ikke være en ren adapatación men han ville fjerne juice (som de gjorde med GPU CUDA-teknologi).

Takk for Gerardo-dataene. Forresten, har du prøvd Manifold i 64 biter?

God notat

Hvis du vil se demonstrasjonsvideoen til Manifold der du kan se platens brutale prosesseringshastighet med CUDA-teknologi - som i tillegg flere kan installeres parallelt og dermed legge til krefter, så lenge det er ledige spor - gå til denne YouTube-URL-en :

http://www.youtube.com/watch?v=1h-jKbCFpnA

En annen bønne for Manifolds historie: 1er native 64 bit SIG program. Og nå, 1er SIG ved å bruke CUDA-teknologien ..

Hilsen